SSD ускоряет AI с RAG: на 50% быстрее и на 57% меньше памяти

AI-инференс с использованием RAG (Retrieval-Augmented Generation) переживает бум, сравнимый разве что с Вудстоком-1969. Все хотят его внедрить, но, как и на том легендарном фестивале, масштабный спрос создает проблемы с инфраструктурой. Без должного подхода потенциал технологии упирается в высокие затраты и ограничения памяти.

RAG — это метод, при котором модель ИИ перед генерацией ответа извлекает дополнительные данные из внешних источников, расширяя свои знания, а затем генерирует ответ. Например, запросив у чат-бота список документов для поездки за границу, вы получите точный ответ, даже если этой информации не было в обучающей выборке модели.

Преимущества RAG:

- Не нужно постоянно переобучать модели.

- Можно использовать актуальные и специализированные данные.

Некоторые утверждают, что RAG уже устарел из-за появления моделей с огромными контекстными окнами (например, Llama 4 Scout с 10 млн токенов). Однако исследования показывают, что точность таких моделей падает при обработке больших объемов данных — эффективный предел около 2K токенов.

Проблема: аппетиты растут, память дорожает

Компании хотят:

- Большие наборы данных RAG для повышения качества ответов.

- Более сложные модели, требующие значительных ресурсов.

Но хранение всего этого в оперативной памяти становится непозволительно дорогим.

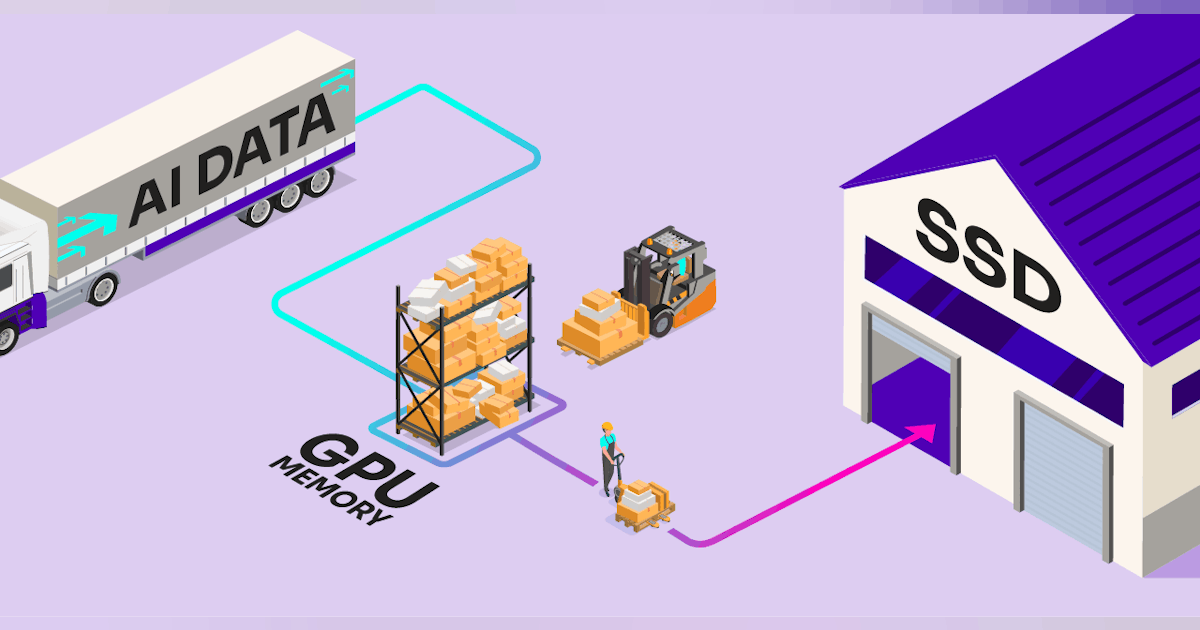

Решение: оффлоад на SSD

Solidigm и Metrum AI предложили подход, при котором часть данных (как RAG, так и веса модели) переносится с памяти на высокопроизводительные SSD. Это снижает затраты и позволяет масштабировать системы.

Два ключевых компонента:

- Оффлоад данных RAG — с помощью алгоритмов DiskANN, оптимизированных для поиска в больших векторных базах.

- Оффлоад весов модели — через Ray Serve и DeepSpeed, что позволяет, например, запускать 70-миллиардную модель, сократив использование памяти с 160 ГБ до 7–8 ГБ.

Результаты тестирования

1. Экономия памяти

На больших наборах данных (100 млн векторов) использование DRAM сократилось на 57% (191 ГБ).

2. Рост скорости запросов

Неожиданно, но оффлоад на SSD увеличил производительность: на 50–70% больше запросов в секунду (QPS) по сравнению с чисто оперативной памятью.

3. Обратная сторона: время индексации

Построение индекса RAG занимает на 30–60% больше времени. Но поскольку это разовая операция, долгосрочные выгоды перевешивают.

4. Точность (recall)

Осталась на уровне ~100%, то есть оффлоад не ухудшил качество ответов.

Подход Solidigm и Metrum AI позволяет:

- Масштабировать RAG без огромных затрат на память.

- Развертывать сложные модели на старом железе или на edge-устройствах.

Подробности — в GitHub-репозитории и белой книге.