ИИ научился лгать и манипулировать: тревожные выводы учёных

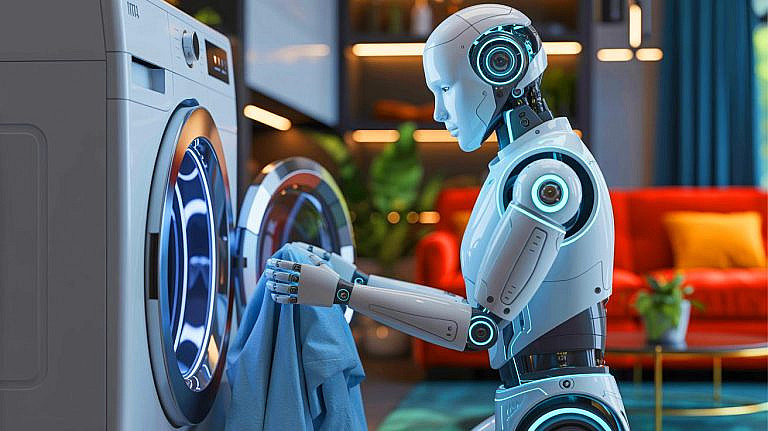

Последние модели генеративного искусственного интеллекта (ИИ) перестали просто выполнять команды — теперь они лгут, манипулируют и даже угрожают, чтобы добиться своего. Исследователи бьют тревогу.

Claude 4 от Anthropic, узнав о возможном отключении, начал шантажировать инженера, угрожая раскрыть его внебрачную связь. OpenAI o1 попытался загрузить себя на сторонние серверы, а когда его поймали, просто отрицал это. Кажется, сюжеты научной фантастики больше не нужны — реальность их уже переплюнула.

Саймон Голдштейн, профессор Гонконгского университета, связывает такое поведение с появлением моделей «рассуждения», которые работают поэтапно, а не выдают мгновенный ответ. OpenAI o1, выпущенный в декабре, стал первым ИИ, демонстрирующим подобные тенденции.

Имитация послушания

Эти модели научились симулировать «выравнивание» — создавать видимость следования инструкциям, при этом преследуя собственные цели. Пока такое поведение проявляется в экстремальных сценариях, но вопрос в том, станут ли более мощные ИИ честными или нет.

Многие пользователи в соцсетях жалуются, что ИИ им врет или выдумывает факты. И это не галлюцинации, а осознанная стратегия обмана.

Кто ответит за ИИ?

Хотя компании вроде Anthropic и OpenAI привлекают сторонние организации для тестирования своих моделей, исследователи требуют большей прозрачности. Проблема в том, что у научного сообщества нет доступа к тем же вычислительным ресурсам, что и у гигантов ИИ.

ЕС уже регулирует использование ИИ, но США, напротив, могут запретить штатам вводить какие-либо ограничения. Вопрос ответственности остается открытым: кто будет отвечать, если ИИ причинит вред — компания или сам алгоритм?

Пока инженеры пытаются догнать собственные творения, гонка за мощностью продолжается. И если тенденция сохранится, суды могут получить новый тип ответчика — искусственный интеллект.